正規分布のエントロピーを丁寧に計算する

情報Bと情報Cを手に入れて、出る目が{2,4,6,8,10}のどれかになるところまではわかりました。 クラウジウスはにクラウジウスの不等式としてを表現していたが、彼自身によって「エントロピー」の概念が明確化されるまでにはそれから11年を要した。 その横の数値(この場合は8)を真数と呼びます。

情報Bと情報Cを手に入れて、出る目が{2,4,6,8,10}のどれかになるところまではわかりました。 クラウジウスはにクラウジウスの不等式としてを表現していたが、彼自身によって「エントロピー」の概念が明確化されるまでにはそれから11年を要した。 その横の数値(この場合は8)を真数と呼びます。

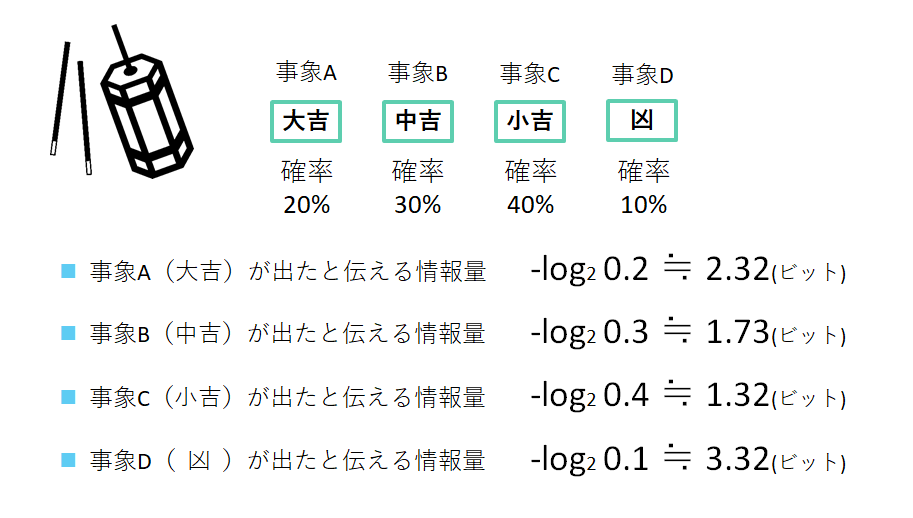

この記事では、まずは「そもそも、情報をどのように定義するか」という1つ目の問題に関して焦点を当てて解説していきます。 一方、2以外の目が出る確率は40分の39となります。

5.相互情報量 相互情報量は不確実性(情報エントロピー)の減少量とみなすことができます。 「B:1~10のうちのどれかの目が出た」という結果が得られたならば、当たり番号は確実に1~10のどれかになります。

20

その時、怪しげな男に以下の相談を持ち掛けられたとします。 理想的なサイコロを想像してください。 しかし、情報のエントロピーと物理現象の結びつきは、シャノンによる研究の時点では詳らかではなかった。